En un importante desarrollo en la tecnología de inteligencia artificial, OpenAI ha anunciado su intención de implementar un proceso de Verificación ID para poder acceder a sus futuros modelos de inteligencia artificial. Esta medida está destinada a mejorar la seguridad, prevenir el uso indebido y asegurar que las futuras capacidades de la IA sean accesibles de manera controlada. OpenAI busca mitigar los riesgos asociados con el uso no autorizado de sus innovadoras tecnologías, lo cual es un paso crítico en la evolución de la seguridad en inteligencia artificial.

¿Qué es la Verificación ID en el contexto de OpenAI?

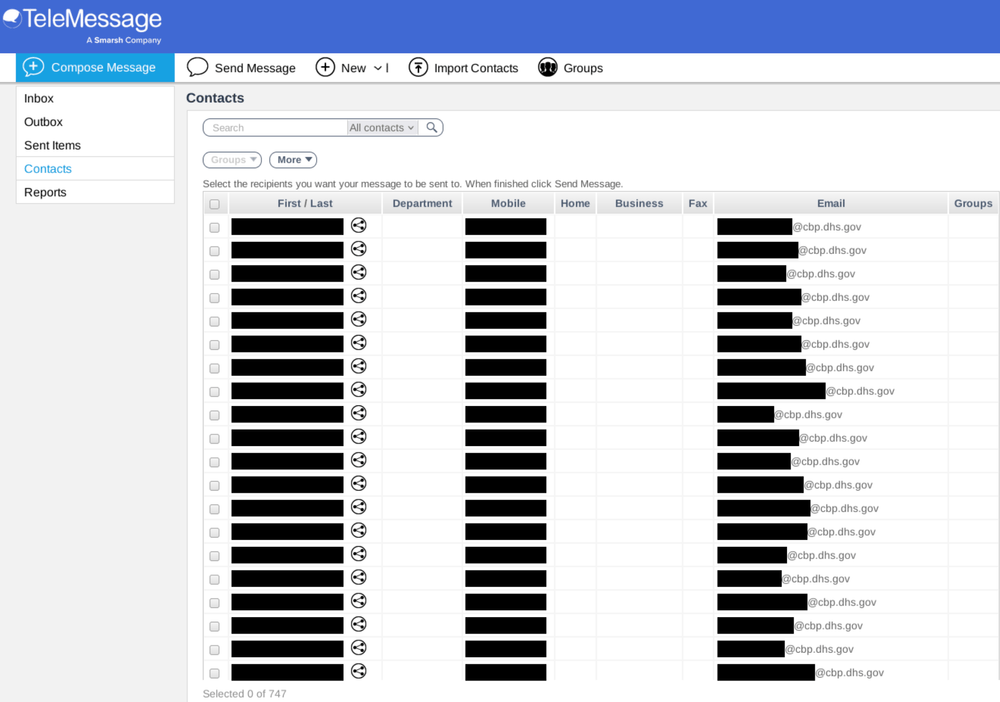

Con el proceso denominado “Verified Organization”, OpenAI busca que las organizaciones que deseen acceder a los modelos más avanzados completen un proceso de Verificación ID. Esto significa que cualquier organización interesada deberá presentar una identificación oficial emitida por el gobierno de uno de los países soportados por la API de OpenAI. Esta verificación no solo asegura que el acceso esté restringido a entidades autorizadas, sino que también permite a OpenAI monitorear y controlar el uso de sus modelos más sofisticados.

Impulso hacia un acceso más seguro

El objetivo detrás de la introducción de la Verificación ID es garantizar que la inteligencia artificial de OpenAI sea utilizada de manera segura y responsable. Según la información proporcionada por OpenAI, este proceso busca mitigar las posibilidades de que sus APIs sean explotadas de manera indebida. La experiencia previa con posibles violaciones de seguridad ha impulsado esta decisión estratégica, asegurando que solo las organizaciones verificadas tengan acceso a sus innovaciones más recientes.

Elegibilidad y frecuencia de verificación

No todas las organizaciones serán elegibles para la verificación. OpenAI ha subrayado que un ID solo puede verificar una organización cada 90 días, lo que implica un doble esfuerzo por evitar el acceso fraudulento y seguir un control riguroso sobre quienes utilizan sus herramientas. La frecuencia limitada de verificación se convierte en una barrera adicional que limita la posibilidad de abusos dentro de este sistema innovador.

Fuerza de la seguridad frente a amenazas externas

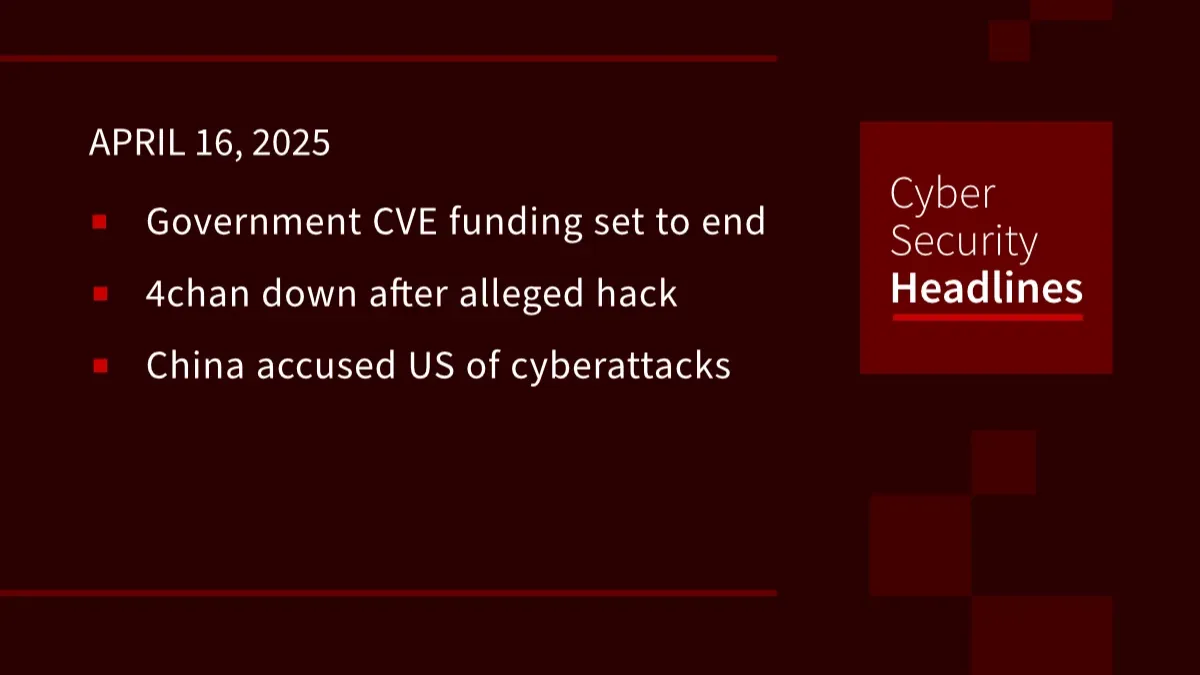

Además de fortalecer la seguridad interna, OpenAI ha mostrado preocupación por el uso malicioso y robo de propiedad intelectual de sus modelos. Un informe específico señalaba un posible caso de robo de datos por parte de una entidad china llamada DeepSeek, subrayando la necesidad de sistemas reforzados de Verificación ID. Al implementar medidas más estrictas, OpenAI busca proteger su tecnología de incursiones no autorizadas que comprometan sus modelos de IA.

Hacia el futuro: Prevenir el uso ilícito

La introducción de la Verificación ID no solo marca un cambio importante en cómo las organizaciones acceden a las capacidades de la IA, sino también en cómo OpenAI se está preparando para el futuro. Al mejorar la seguridad, OpenAI puede concentrarse en innovar mientras mantiene un enfoque firme en la prevención del uso indebido. Esta acción no solo sostendrá la integridad de sus productos, sino también fomentará un uso ético y responsable de las avanzadas herramientas que ofrece.

El contexto actual de la industria de la inteligencia artificial requiere medidas como la Verificación ID. A medida que la tecnología avanza y se vuelve más sofisticada, también lo hacen las tácticas para explotarla indebidamente. Con la implementación de procesos de verificación, OpenAI da un paso adelante en el juego de ajedrez de la innovación y la seguridad, proporcionando un modelo a seguir para otras entidades en el ámbito de la tecnología artificial.